Googles neues Bildmodell im Praxistest: Was es wirklich kann

Aug 28

/

Timo Springer

Willkommen zur neuesten Ausgabe

von DECAID Artificial Teams!

In den letzten Wochen brodelte es in der KI-Community. Auf der anonymen Evaluierungsplattform LMArena tauchte ein neues Bildbearbeitungsmodell namens »nano-banana« auf, deklassierte über Nacht die gesamte Konkurrenz und sicherte sich, basierend auf Millionen von Community-Votes, mit riesigem Vorsprung den ersten Platz auf der Plattform. Die Ergebnisse waren so beeindruckend, die Bearbeitungsmöglichkeiten so präzise, dass alle rätselten: Wer steckt dahinter?

Diese Woche lüftete Google das Geheimnis: »nano-banana« ist in Wahrheit Gemini 2.5 Flash Image, ein massives Upgrade für die Bildgenerierung und -bearbeitung in Gemini. Und dieses Update bringt einige wesentliche Veränderungen mit sich.

Diese Woche lüftete Google das Geheimnis: »nano-banana« ist in Wahrheit Gemini 2.5 Flash Image, ein massives Upgrade für die Bildgenerierung und -bearbeitung in Gemini. Und dieses Update bringt einige wesentliche Veränderungen mit sich.

Aber seht selbst: Die Power in der Praxis

Bevor wir in die Details eintauchen, lasse ich die Ergebnisse für sich sprechen. Ich habe das neue Modell einem Härtetest unterzogen, und die Resultate zeigen, wie mächtig die neuen Möglichkeiten im Alltag sind:

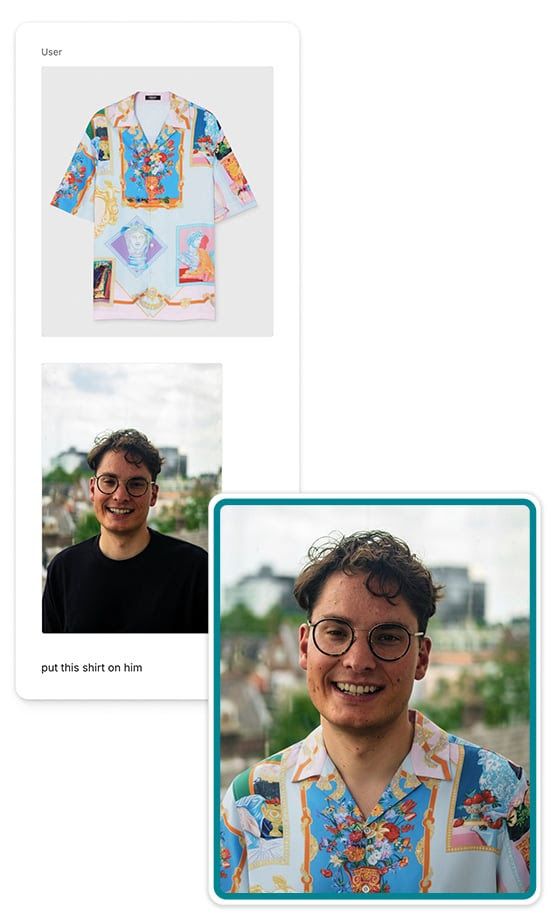

Multi-Image Fusion & Konsistenz: Ich habe ein Foto von mir und ein Produktfoto eines Hemdes hochgeladen. Der simple Prompt »put this shirt on him« hat genügt. Das Ergebnis ist überzeugend: Das Hemd passt perfekt, die Lichtstimmung stimmt und vor allem – mein Gesicht wurde absolut konsistent beibehalten.

Multi-Image Fusion & Konsistenz: Ich habe ein Foto von mir und ein Produktfoto eines Hemdes hochgeladen. Der simple Prompt »put this shirt on him« hat genügt. Das Ergebnis ist überzeugend: Das Hemd passt perfekt, die Lichtstimmung stimmt und vor allem – mein Gesicht wurde absolut konsistent beibehalten.

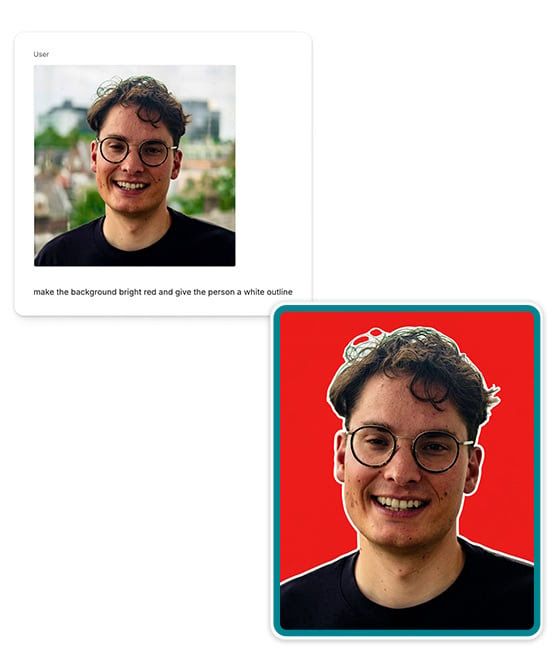

Präzise, lokale Bearbeitung: Ein einfaches Porträtfoto von mir wurde mit dem Prompt »make the background bright red and give the person a white outline« versehen. Die KI hat die Anweisung perfekt umgesetzt, ohne das eigentliche Motiv (mich) zu verändern. Ideal für schnelle Social-Media-Visuals.

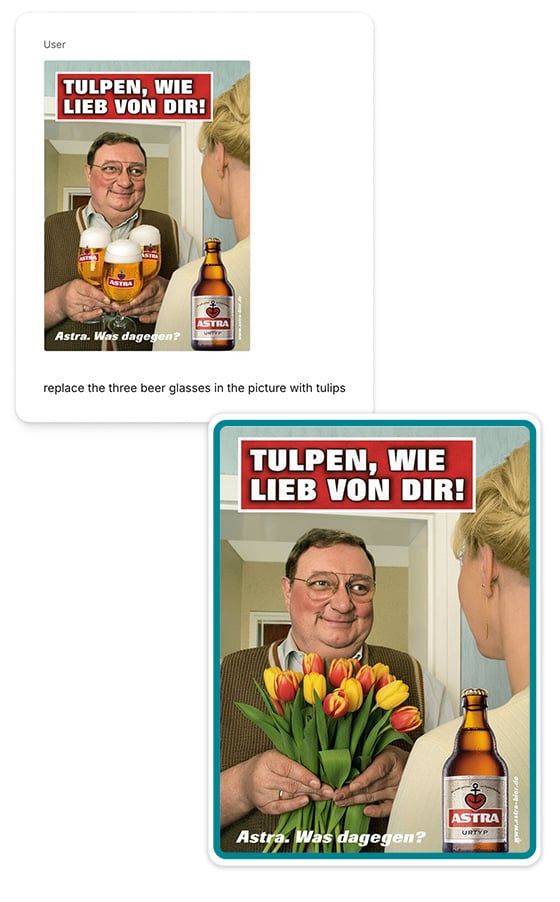

Komplexe Objekt-Ersetzung im Werbekontext: Ich habe eine alte Astra-Bier-Werbung genommen und die drei Biergläser durch Tulpen ersetzt. Auch hier hat die KI den Stil und die Lichtverhältnisse des Originals gut adaptiert und ein stimmiges neues Bild geschaffen.

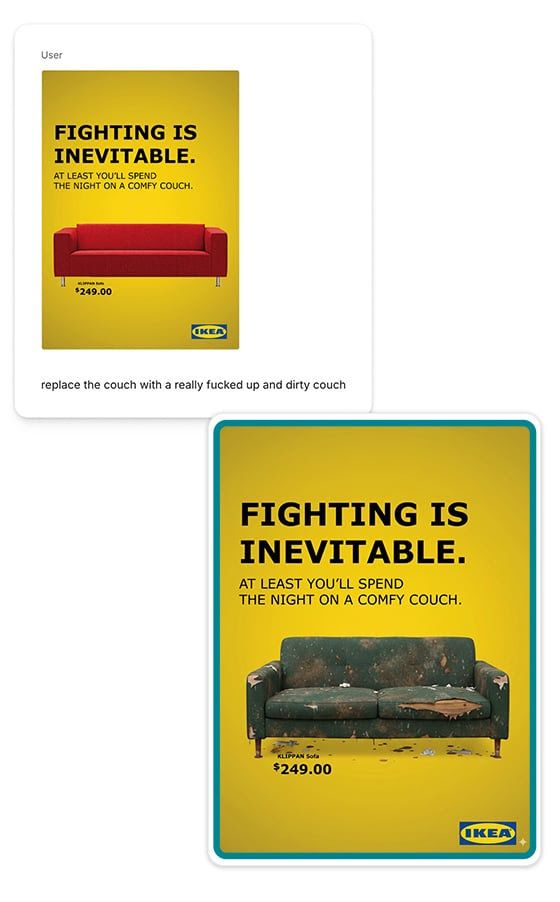

Kreative Transformation mit Markenbezug: In einer IKEA-Werbung habe ich die saubere Couch mit dem Prompt »replace the couch with a really fucked up and dirty couch« ausgetauscht. Das Ergebnis spricht für sich und zeigt, wie einfach sich kreative Konzepte und Stimmungen umsetzen lassen.

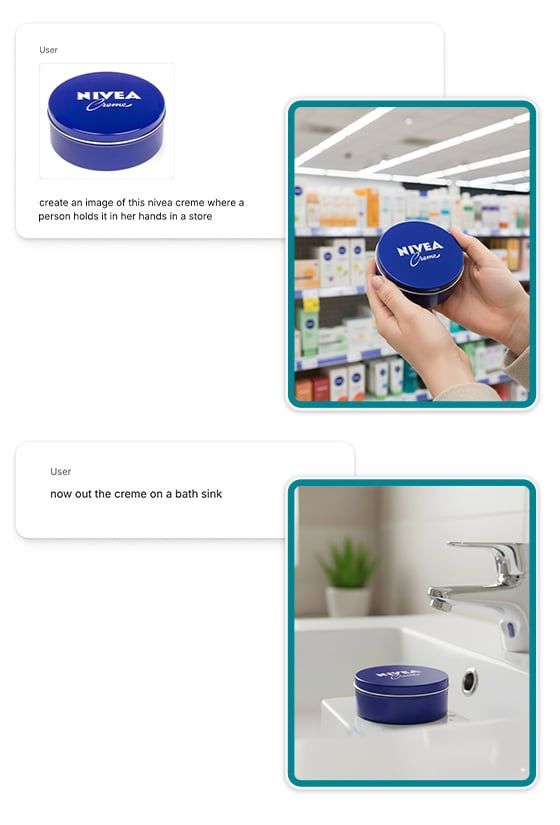

Dynamische Produktfotografie: Ausgehend von einem einzigen Packshot einer Nivea-Dose konnte ich das Produkt mit einfachen Anweisungen in zwei völlig unterschiedliche, fotorealistische Szenen versetzen: einmal in den Händen einer Person in einer Drogerie und einmal auf einem Waschbecken im Badezimmer. Ein perfektes Beispiel dafür, wie man mit minimalem Aufwand eine ganze Bibliothek an Produktbildern erstellen kann.

Der Paradigmenwechsel:Konsistenz ist der neue König

Was dieses Modell so besonders macht, ist nicht nur die Bildqualität. Es ist eine einzige, aber entscheidende Fähigkeit, an der bisher fast alle Modelle gescheitert sind: Konsistenz.

Genau diese Fähigkeit zur präzisen, sprachbasierten Bearbeitung bei gleichzeitiger Konsistenz macht es zum mit Abstand besten Image-Editing-Modell, das wir bisher gesehen haben.

Egal ob du die Farbe eines T-Shirts ändern, eine Person in eine neue Umgebung versetzen oder ein Produkt aus verschiedenen Winkeln zeigen willst – Gemini 2.5 Flash Image schafft es, Charaktere, Gesichter und Objekte über mehrere Bearbeitungsschritte hinweg absolut konsistent zu halten. Kein verzerrtes Gesicht mehr, kein veränderter Hintergrund. Das, was gleich bleiben soll, bleibt gleich.

Genau diese Fähigkeit zur präzisen, sprachbasierten Bearbeitung bei gleichzeitiger Konsistenz macht es zum mit Abstand besten Image-Editing-Modell, das wir bisher gesehen haben.

Ist Fine-Tuning jetzt überflüssig?

Diese Entwicklung wirft eine fundamentale Frage auf, die für unzählige Unternehmen und Kreative entscheidend ist: Brauchen wir überhaupt noch aufwendiges und teures Fine-Tuning von Bildmodellen, um markenspezifische, konsistente visuelle Welten zu erschaffen?

Meine klare Einschätzung: Für 80 % der Anwendungsfälle ist Fine-Tuning ab heute nicht mehr notwendig.

Die Qualität und Konsistenz von Gemini 2.5 Flash Image ist so hoch, dass die meisten Standard-Anforderungen von Marketing- und Kreativ-Teams »out of the box« erfüllt werden. Nur die Top 20 %, die absolute High-End-Qualität benötigen, werden weiterhin auf spezialisierte, fine-getunte Modelle setzen. Für den Rest ist die Ära des Fine-Tunings vorbei.

Ein ehrlicher Blick: Wo das Modell noch an seine Grenzen stößt

Ein weiterer entscheidender Sprung ist die Art der Interaktion. Statt nur einen Befehl abzugeben, kannst du mit dem Bild in einen echten Dialog treten. Dieser »Multi-Turn«-Ansatz erlaubt es dir, iterativ zu arbeiten: »Male die Wände blau«, »Okay, jetzt füge ein Bücherregal hinzu«, »Mache das Regal aus dunklem Eichenholz«. Das passt perfekt zu unserer Philosophie, KI als Sparringspartner zu sehen, nicht als reinen Befehlsempfänger.

Kombiniert wird das mit Geminis tiefem Weltwissen. Das Modell kann Konzepte und Stile anwenden, die im Ursprungsbild gar nicht vorhanden sind. Du kannst ein Foto deines Wohnzimmers hochladen und sagen: »Gestalte diesen Raum im Bauhaus-Stil mit der Farbpalette von diesem Sonnenuntergangsfoto«. Die KI versteht die abstrakten Konzepte und fusioniert sie zu einem neuen, stimmigen Ganzen.

Jetzt selbst ausprobieren: Der "Nano-Banana"-Spielplatz

Theorie ist gut, aber nichts geht über die eigene Erfahrung. Google hat mit dem AI Studio eine fantastische Möglichkeit geschaffen, das neue Modell direkt und unkompliziert zu testen. Lade ein eigenes Bild hoch, probiere ein paar Bearbeitungen aus und überzeuge dich selbst von der Qualität.

Hier geht's direkt zum Testen: https://aistudio.google.com/prompts/new_chat

10 Use Cases, die für Marketer und Kreative jetzt sofort relevant sind

Was bedeutet das konkret für den Arbeitsalltag? Hier sind 10 typische Anwendungsfälle, bei denen das neue Modell seine Stärken voll ausspielt:

3. A/B-Testing für Social Ads: Ändere nur eine einzige Variable in einem Bild (z.B. die Farbe eines Produkts oder die Kleidung eines Models) für präzise Performance-Tests.

4. Personalisierte Marketingmaterialien: Füge Elemente, die einen Kunden repräsentieren, nahtlos in bestehende Bilder ein, um hyper-personalisierte Angebote zu erstellen.

5. Effizientes Storyboarding: Entwickle eine visuelle Geschichte mit konsistenten Charakteren und Schauplätzen, indem du Szenen iterativ bearbeitest.

6. Einheitlicher Social-Media-Feed: Erstelle eine Serie von Bildern für Instagram oder LinkedIn, die alle einer einheitlichen visuellen Ästhetik und Tonalität folgen.

7. Virtuelles Home-Staging für Immobilien & Möbel: Zeige eine Couch oder ein ganzes Zimmer-Setup in hunderten verschiedenen Stilen, Farben und Materialien.

10. Erstellung von Brand-Assets: Generiere eine ganze Bibliothek an markenspezifischen Icons, Illustrationen oder Hintergründen mit einem konsistenten Stil.

1. Konsistente Kampagnen-Visuals: Erstelle eine Hauptfigur oder ein Maskottchen und setze es in dutzende verschiedene Szenarien und Werbemittel, ohne dass sich das Aussehen verändert.

2. Dynamische Produktfotografie: Nimm ein einziges Produktfoto und platziere es in unzählige verschiedene Umgebungen – vom Strand bis zur urbanen Loft-Wohnung.

2. Dynamische Produktfotografie: Nimm ein einziges Produktfoto und platziere es in unzählige verschiedene Umgebungen – vom Strand bis zur urbanen Loft-Wohnung.

3. A/B-Testing für Social Ads: Ändere nur eine einzige Variable in einem Bild (z.B. die Farbe eines Produkts oder die Kleidung eines Models) für präzise Performance-Tests.

4. Personalisierte Marketingmaterialien: Füge Elemente, die einen Kunden repräsentieren, nahtlos in bestehende Bilder ein, um hyper-personalisierte Angebote zu erstellen.

5. Effizientes Storyboarding: Entwickle eine visuelle Geschichte mit konsistenten Charakteren und Schauplätzen, indem du Szenen iterativ bearbeitest.

6. Einheitlicher Social-Media-Feed: Erstelle eine Serie von Bildern für Instagram oder LinkedIn, die alle einer einheitlichen visuellen Ästhetik und Tonalität folgen.

7. Virtuelles Home-Staging für Immobilien & Möbel: Zeige eine Couch oder ein ganzes Zimmer-Setup in hunderten verschiedenen Stilen, Farben und Materialien.

8. Mode-Visualisierung: Präsentiere dasselbe Model in unzähligen verschiedenen Outfits, ohne dass jedes Mal ein neues Foto generiert werden muss.

9. Lokale Bildretusche: Entferne störende Elemente, ändere die Lichtstimmung oder passe Details in einem Bild an, ohne ein komplettes Re-Shooting durchführen zu müssen.

10. Erstellung von Brand-Assets: Generiere eine ganze Bibliothek an markenspezifischen Icons, Illustrationen oder Hintergründen mit einem konsistenten Stil.

Fazit: Vom Generator zum Regisseur

Das Gemini 2.5 Flash Image Update ist mehr als nur ein weiteres Feature. Es markiert den Übergang von reiner KI-Bildgenerierung hin zu echter KI-Bildregie. Wir agieren nicht mehr als Bittsteller, die hoffen, dass die KI das richtige Ergebnis ausspuckt. Wir werden zu Regisseuren, die eine klare Vision haben und die KI als präzises Werkzeug nutzen, um diese Vision Schritt für Schritt zu realisieren.

Dies ist ein bedeutender Schritt, der das Potenzial hat, die Art und Weise, wie wir visuelle Inhalte erstellen, nachhaltig zu verändern.

💭 Was bedeutet dieser Sprung für eure kreativen Workflows? Wo seht ihr das größte Potenzial für euer Team? Ich freue mich auf den Austausch!

Copyright © 2025

Lernpfad erfolgreich gestartet

Der ausgewählte Lernpfad wurde deiner Start-Seite hinzugefügt. Du findest alle enthaltenen Kurse auf dieser Seite.

Die DECAID Academy 3.0 ist live!

- Neue Kurse: Du findest unzählige neue Inhalte in der Academy

- Neue Kursstruktur: Übungen, Cheat Sheets, Prompt Vorlagen,... warten auf dich

- Zwei Sprachen: Du kannst jetzt auf deutsch und englisch arbeiten

- Neue Kursstruktur: Übungen, Cheat Sheets, Prompt Vorlagen,... warten auf dich

- Zwei Sprachen: Du kannst jetzt auf deutsch und englisch arbeiten